Tous les professionnels savent que le référencement efficace d’une page sur Google est composé de deux éléments uniques : la génération de liens entrants et l’optimisation de la page elle-même. C’est ce dernier point qui nous intéresse aujourd’hui. Nous parlons ici de référencement naturel, ce qui implique que nous allons faire en sorte de plaire à Google, par le biais d’une méthode durable, et, espérons-le, concluante, afin d’obtenir du succès.

Optimiser l’architecture du site

L’architecture est la première phase et la plus importante. Il est impossible qu’une page individuelle d’un site Web ait les meilleures chances d’être indexée, d’apparaître dans les résultats de recherche et d’être classée, si la structure générale du site n’est pas optimisée.

Bien qu’il n’y ait pas deux sites Web identiques, la majorité des spécialistes de la recherche estiment que la mise en page d’un site doit généralement suivre un flux logique et comporter une hiérarchie des pages pour faciliter l’exploration. Cela aide autant les utilisateurs que les robots à comprendre le contenu de votre site. Pour cela, vous pouvez faire appel à une agence seo si vous n’avez pas les compétences techniques requises.

Les contenus dupliqués

Pour le référencement naturel d’un site Web, les textes dupliqués sont un sérieux obstacle à son succès. Si Google découvre ce type de contenu sur votre site ou votre blog, vous risquez de recevoir une pénalité Panda, ce qui n’améliorera aucunement votre situation. Utilisez les outils Killduplicate ou Copyscape pour savoir où ils se trouvent. Vous pouvez opter pour l’utilisation d’une balise « rel=canonical » afin d’indiquer aux moteurs de recherche la page à privilégier à des fins de référencement, en cas de contenu dupliqué.

Le maillage interne

Il correspond à la formation d’un lien hypertexte dans une page qui renvoie vers une autre page de votre site, intimement liée à l’arborescence de votre site. L’usage de ce maillage doit être limité et ne doit être effectué que lorsque la construction de ces liens est cohérente : on parle souvent de glissement sémantique. De plus, cette activité a l’avantage d’aider le moteur de recherche à déterminer le thème de vos sites. En ce qui concerne l’utilisateur, la mise en réseau interne présente des bénéfices indiscutables en termes de capacités de ce dernier à naviguer sur votre site.

Le robots.txt

Les fichiers « robots.txt » se trouvent sur chaque site Web et permettent au propriétaire du site d’indiquer à Google de suivre un certain chemin vers les pages qu’il souhaite indexer. En évaluant ce fichier, le référent web peut s’assurer que les pages sont facilement accessibles au public visé. Il est requis par le crawler afin d’explorer votre site dans son intégralité.

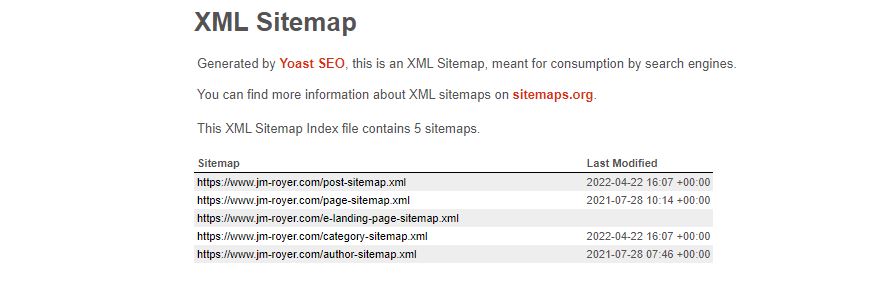

Le sitemap

Le sitemap est le plan du site, et il donne une liste d’URLs pour les moteurs de recherche sous la forme d’un fichier de type XML. Il a d’abord été développé par Google, et est maintenant utilisé par une variété de moteurs de recherche. Il est souvent situé au niveau de la racine d’un site Web et accessible depuis l’URL nomdusite.fr/sitemap.xml. Il est très utile pour les sites comportant une grande quantité de pages.